Mit dem weltweit ersten KI-Gesetz, das im vergangenen März vom Europäischen Parlament verabschiedet wurde, ist ein umfassendes Regulierungssystem geschaffen worden, um EU-Bürgerinnen und -Bürger vor den potenziellen Gefahren von KI zu schützen. Eine Frage bleibt dabei aber unbeantwortet: wie viel Bias ist eigentlich zu viel?

Das neue KI-Gesetz ist gutes Governance-Handwerk

An dieser Stelle bekenne ich mich als Fan des neuen KI-Gesetzes. Grundsätzlich lebe ich gern in einem Land, in dem es so etwas wie Social Scorings, prädiktive Strafverfolgung, eine automatisierte Bewertung von Schulqualität oder eine Beurteilung meiner Kreditwürdigkeit anhand meiner favorisierten Supermärkte nicht gibt.

Das europäische KI-Gesetz hat das Zeug dazu, nachhaltige Schutzmechanismen gegen solche Formen abusiver KI zu etablieren. Es regelt nicht nur, unter welchen Bedingungen welche Einschränkungen für eine KI bestehen – Je intensiver der potenzielle Grundrechtseingriff durch die Anwendung einer KI, desto strikter die Auflagen. Angelegt wird auch ein umfassendes Kontrollsystem zur Zulassung von KI-Anwendungen einschließlich einer neuen EU-Behörde und nationaler Kontrollstellen.

Spannend in Bezug auf die Frage, was diese Kontrollstellen dann eigentlich genau kontrollieren sollen, ist unter anderem die Mission KI. Im Rahmen des vom Bund finanzierten Projekts wird deutschlandweit verteilt in mehreren KI-Qualitäts- und Innovationszentren unter anderem erprobt, wie die KI-Zulassungsstellen der Zukunft aussehen können. Ich glaube, allein diese Debatte, wie eine effektive KI-Regulierung aussehen muss und umgesetzt werden kann, setzt schon wesentlich mehr Innovationsimpulse frei als sie Unkenrufen zufolge von dem neuen KI-Gesetz unterdrückt werden – von der weltweiten Strahlkraft des Gesetzes ganz zu schweigen. Man kann Parallelen zur deutschen Energiewende ziehen: wenn es eine klare Vision gibt, entstehen die Innovationen auf dem Weg zum Ziel. Wenn Kernkraft und Kohle ausgeschlossen werden, profitiert davon die Forschung in Wasserstoff, Wärmepumpen oder Batteriezellen. Wenn abusive KI verboten ist, profitiert davon die Forschung in und Verbreitung von Trustworthy AI.

Leinenpflicht: Diese kleine Szene aus der Feder der Hamburger Illustratorin Maren Amini zeigt, dass die Bändigung von KI ein zähes Ringen ist. (© Maren Amini)

Entering the Graubereich

Das europäische KI-Gesetz unterscheidet vier Risikostufen: verbotene Anwendungen mit inakzeptablem Risiko (bspw. KI zur biometrischen Massenüberwachung), Hochrisikoanwendungen bei denen europäische Grundrechte betroffen sein können und die daher unter strengen Auflagen stehen (bspw. KI in der medizinischen Diagnostik) sowie begrenzte und minimale Risikoanwendungen (bspw. Chatbots oder KI-gesteuerte Spam-Filter).

Der Zusammenhang zwischen rechtlichem Tatbestand und Rechtsfolge ist bei den verbotenen Anwendungen ziemlich klar. Wenn es sich um einen der im KI-Gesetz genannten Fälle handelt, dann ist eine Anwendung verboten. Bei den KI-Anwendungen mit begrenztem oder minimalem Risiko wiederum sind keine persönlichen Rechtsgüter im kritischen Maße betroffen. Verschwommener wird es jedoch im Hochrisikobereich. Hier zeigt sich aus meiner Sicht die Achilles-Ferse der europäischen KI-Regulierung.

Ein ganz fiktiver Fall aus einem ganz fiktiven Unternehmen

Stellen wir uns einen Fall vor, der im Rahmen des KI-Gesetzes als Hochrisikoanwendung klassifiziert, aber erlaubt ist. Ähnlichkeiten zu realen Unternehmen und Personen sind rein zufälliger Art. Das Management in diesem fiktiven Unternehmen entscheidet sich, eine KI-basierte Software zur Erfassung der Mitarbeitendenproduktivität einzusetzen. Die Software misst nicht nur, mit welchen virtuellen Tätigkeiten die Beschäftigten ihre Arbeitszeiten verbringen, sondern misst auch ihren Output und erstellt auf dieser Grundlage Leistungsbewertungen. Die Leistungsbewertungen werden als Grundlage für Entwicklungsgespräche zwischen den Mitarbeitenden und ihren Führungskräften genommen und dienen auch einer automatisierten Zuteilung von Arbeitsaufträgen, sodass jede Aufgabe zu der Person kommt, die sie besonders effektiv erledigen kann. Die Daten dieser so entwickelten Personenprofile werden auch zum KI-basierten Training der Personalauswahltests des Unternehmens verwendet: welche Fähigkeiten werden in dem Unternehmen gebraucht, was für ein Typus von Mitarbeitenden ist besonders erfolgreich?

Ist sowas okay? Das KI-Gesetz sagt, nein, wenn – stark verkürzt – von der KI-Software nachteilige Auswirkungen für die europäischen Grundrechte der Beschäftigten oder Bewerbenden des Unternehmens zu erwarten wären. Der typische Fall für diese adverse impacts ist ein Verstoß gegen das europäische Gleichheitsgebot. Sicher haben Sie schon einmal von diskriminierender KI gehört oder auch etwas über die von Amazon entwickelte Software zum Bewerbungsranking gelesen, die Frauen benachteiligt hat. In unserem fiktiven Fall wären nun ähnliche Effekte denkbar, denn die Leistungsbewertung der Beschäftigten hängt in der Praxis von einer ganzen Menge impliziter Aspekte ab, die auch an ihre soziale Identität anknüpfen: wie viel traut eine Führungskraft einer Person zu und auf was für Vorurteilen beruht diese Einschätzung, wie flexibel kann eine Person sein, wie viel mentalen Ballast schleppt sie mit sich herum.

Nüchtern betrachtet: es gibt keine perfekten menschlichen Entscheidungen und auch keine perfekte KI

Das Problem mit der Frage, wie viel Diskriminierung zu viel ist, lässt sich an folgendem Beispiel veranschaulichen. Es ist allgemein bekannt, dass KI-basierte Gesichtserkennungssoftware nicht mit gleicher Wahrscheinlichkeit die Gesichter von Menschen unterschiedlicher Hautfarben oder mit unterschiedlichen Gesichtsphysiognomien erkennen kann. Das Problem hat auch dazu beigetragen, dass die großen amerikanischen Software-Hersteller öffentlich verkündet haben, ihre Gesichtserkennungssoftware nicht mehr der amerikanischen Polizei zur Verfügung zu stellen, solange ein rechtskonformer Einsatz dieser Softwares nicht gewährleistet ist. Danke, Amazon, Microsoft und IBM!

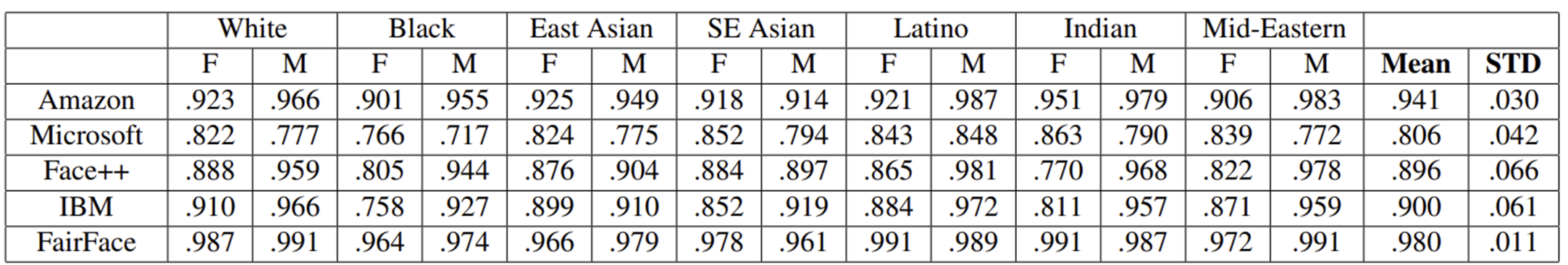

Ursächlich für den Bias in Gesichtserkennungssoftware waren die zum Anlernen der KI genutzten Trainingsdatensätze. In der Folge haben Wissenschaftlerinnen und Wissenschaftler eine Reihe von diversen Trainingsdatensätzen erstellt. Einer davon ist der sogenannte FairFace-Datensatz von Kärkkäinen und Joo. Die beiden Forschenden haben getestet, wie hoch der Vorhersageerfolg unterschiedlicher Gesichtserkennungssoftwares für ihren Datensatz ist und die Ergebnisse nach race und Geschlecht klassifiziert. Ethisch ist so eine Zuschreibung von race und Geschlecht nicht unumstritten – aber es ist ein Weg, um Diskriminierung durch KI sichtbar zu machen. Die Erfolgswahrscheinlichkeiten für eine korrekte Identifikation der Gesichter der unterschiedlichen Kategorien sind in Tabelle 1 dargestellt

Tabelle 1: Klassifikationsgenauigkeit einer Reihe von Gesichtserkennungssoftware auf einen unter Diversitätskriterien erstellten Datensatz (Tabelle verkürzt aus Kärkkäinen/Joo 2021)

Aus Tabelle 1 geht zum Beispiel hervor, dass die Performance der Microsoft-Software zum Testzeitpunkt am lausigsten gewesen ist und – vielleicht nicht überraschend – die eigene Software des FairFace-Teams die höchste Vorhersagegenauigkeit aufwies. Die Tabelle zeigt zudem, dass die einzelnen Softwares sehr unterschiedliche Stärken-Schwächen-Profile haben. Während die Microsoft-Software bei schwarzen Männern die niedrigste Vorhersagekraft aufwies, waren es bei Amazon und IBM schwarze Frauen. Vor allem zeigt der Test aber, dass selbst die beste Software im Test maximal eine 99%-Vorhersagesicherheit erreicht hat. Aber was heißt das für die Praxis? Sind diese KI-Softwares diskriminierend?

Problematisch wird es dort, wo KI-Recht aufhört, und Antidiskriminierungsrecht anfängt

Das EU-KI-Gesetz verlangt, dass KI-Hochrisikosysteme ein »angemessenes« Niveau von Genauigkeit, Robustheit und Cybersicherheit aufweisen. Hierzu will man laut Gesetzestext u.a. internationale und nationale Normungsbehörden zur Entwicklung von Standards und Richtwerten auffordern. Diese werden sich dann zum Diskriminierungsschutz natürlich am Antidiskriminierungsrecht orientieren.

Das seit längerem etablierte US-amerikanische und das in den Nullerjahren entwickelte europäische Antidiskriminierungsrecht kommen hinsichtlich der Frage, wie viel Diskriminierung zu viel ist, zu unterschiedlichen Einschätzungen. Schauen wir wieder auf die KI-Software zur Bewertung von Bewerbenden und Beschäftigten in unserem fiktiven Unternehmen. In diesem Fall ist der Diskriminierungsschutz durch das Allgemeine Gleichstellungsgesetz (AGG) geregelt. Das AGG würde sagen, wenn von 100 Bewerbenden bei Unternehmen X auch nur eine Person regelmäßig aufgrund ihres Geschlechts, ihrer Ethnie, ihres Alters oder anderer im Gesetz genannter Merkmale aussortiert würde, ohne dass dies aus anderen Gründen erforderlich erscheint, liegt durch die KI-Software eine mittelbare Benachteiligung vor und die Software darf nicht eingesetzt werden.

Die USA sind da pragmatischer. So hat sich Ende der siebziger Jahre in der amerikanischen Verwaltungspraxis als Daumenregel die sogenannte 4/5ths rule entwickelt. Wenn die soziale Gruppe, zu der eine Person gezählt werden kann, in Einstellungs- und Beförderungsprozessen nur 80% der Erfolgschancen einer sozialen Vergleichsgruppe erreicht, ist dies ein Indikator für eine weiter zu prüfende Diskriminierung. Kontrolliert werden die Erfolgschancen unterschiedlicher sozialer Gruppen durch sogenannte Adverse-Impact-Analysen, bei denen die Daten aus den Auswahl- und Beförderungsprozesse einer Organisation über mehrere Jahre hinweg betrachtet werden, um systematische Muster von Benachteiligung zu identifizieren.

In unserer eigenen Forschung sehen wir, dass Deutschland zwar auf dem Papier einen strengeren Diskriminierungsschutz als die USA aufweist. Eine konsequente Kontrolle in Form der genannten Adverse-Impact-Analysen, ob Verfahren in Unternehmen den Anforderungen des AGG entsprechen, findet jedoch nicht statt. Laut AGG muss eine mittelbare Benachteiligung durch einen Algorithmus lediglich plausibel sein – zahlenmäßige Maßstäbe dafür, wie viel Diskriminierungswahrscheinlichkeit zu viel ist, fehlen aber komplett (siehe dazu auch unser Beitrag Verborgene Diskriminierung in mehrstufigen Einstellungsverfahren: Eine Analyse). Stattdessen blendet die Rechtswissenschaft die Frage, wie man mittelbare Diskriminierung sichtbar macht und wie viel zu viel ist, gegenwärtig aus. Das macht wahrscheinlich, dass hier gut gemeinte Regeln zum Diskriminierungsschutz geschaffen wurden, die praktisch aufgrund ihrer Rigidität nicht umsetzbar sind.

In Bezug auf KI-Systeme benötigen wir einen noch stärkeren Austausch zwischen Computerwissenschaft, Technikethik und Rechtswissenschaft zu der Frage, wo eigentlich die letztlichen rechtlichen Benchmarks für die Zulassungskontrollen von Hochrisiko-Systemen im Sinne des KI-Gesetzes liegen sollen. Wie gesagt: das 100%-ig sichere System gibt es nicht. Die Vorhersagegenauigkeit insbesondere neuartiger KI-Anwendungen oder bei Anwendungen mit schwer vorherzusagenden Outcomes (wie bei unserem Unternehmen X) liegt freilich deutlich darunter.

Was denken Sie, wie sich Diskriminierungsschutz und KI-Entwicklung in Einklang bringen lassen? Sollten Unternehmen und Behörden zur regelmäßigen Durchführung von Adverse-Impact-Analysen verpflichtet werden? Brauchen wir einen pragmatischen Antidiskriminierungsschutz nach Vorbild der USA oder Großbritannien? Wir sind gespannt auf Ihre Meinung!

Weiterlesen: Dieser Beitrag ist Teil der Ausgabe 1/24 unseres Magazins »FORWARD zum Schwerpunktthema KI in der Arbeitswelt. Im Magazin geht es um zentrale Fragen wie: Wie machen wir KI für Unternehmen und Mitarbeitende greifbar? Wo sind KI-Anwendungen sinnvoll? Welche Rolle spielt Ethik im KI-Einsatz?

Leselinks:

- Studie: Potenziale Generativer KI für den Mittelstand

- Rechtsgutachten: Automatisch benachteilligt – Das AGG und der Schutz vor Diskriminierung durch algorithmische Entscheidungssysteme (.pdf)

- Amazon-Fall zu diskriminierenden Effekten von KI bei der Personalauswahl

- Artikel zum Thema faire Gesichtserkennung (.pdf)

Kategorien: Künstliche Intelligenz, Zukunftstechnologien

Tags: Diskriminierung in Einstellungsverfahren, Diskriminierungsschutz, recruitFAIR – Einstellungsprozesse diskriminierungsfrei gestalten